Incident 37: L'outil de recrutement expérimental d'Amazon aurait révélé des préjugés sexistes dans les classements des candidats.

Outils

Entités

Voir toutes les entitésClassifications de taxonomie CSETv0

Détails de la taxonomieProblem Nature

Specification

Physical System

Software only

Level of Autonomy

Medium

Nature of End User

Expert

Public Sector Deployment

No

Data Inputs

Resumes

Classifications de taxonomie CSETv1

Détails de la taxonomieIncident Number

37

Risk Subdomain

1.1. Unfair discrimination and misrepresentation

Risk Domain

- Discrimination and Toxicity

Entity

AI

Timing

Post-deployment

Intent

Unintentional

Rapports d'incidents

Chronologie du rapport

Amazon a abandonné un outil "sexiste" qui utilisait l'intelligence artificielle pour décider des meilleurs candidats à embaucher.

Les membres de l'équipe travaillant sur le système ont déclaré qu'il s'était effectivement appris que les cand…

Amazon a abandonné un outil interne "sexiste" qui utilisait l'intelligence artificielle pour trier les candidatures.

L'IA a été créée par une équipe du bureau d'Amazon à Édimbourg en 2014 afin de trier automatiquement les CV et de sélection…

Amazon a découvert un problème avec l'utilisation de l'intelligence artificielle pour embaucher : leur IA était biaisée contre les femmes.

La société basée à Seattle a développé des programmes informatiques conçus pour filtrer des centaines…

L'apprentissage automatique, l'une des techniques de base dans le domaine de l'intelligence artificielle, consiste à apprendre aux systèmes automatisés à concevoir de nouvelles façons de faire les choses, en leur fournissant des tonnes de d…

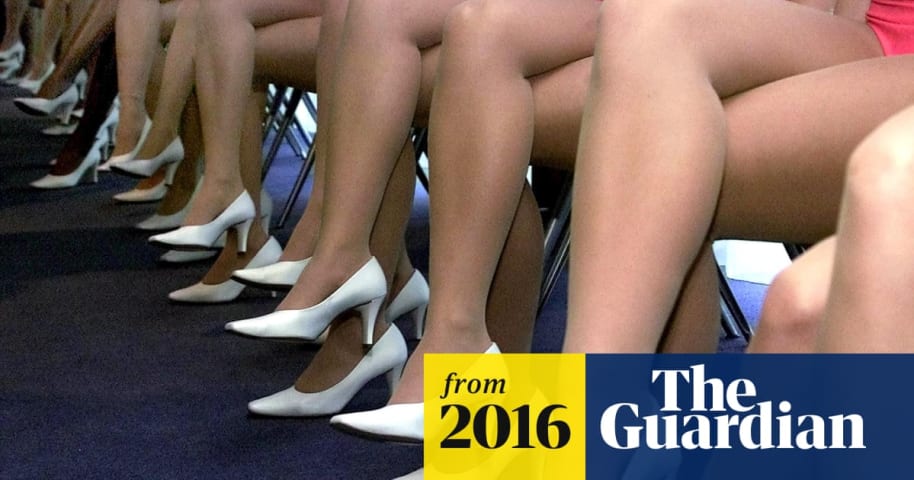

Copyright de l'image Getty Images Légende L'algorithme a répété les préjugés envers les hommes, reflétés dans l'industrie technologique

Un algorithme testé comme outil de recrutement par le géant en ligne Amazon était sexiste et a dû être a…

SAN FRANCISCO (Reuters) - Les spécialistes en apprentissage automatique d'Amazon.com Inc. ont découvert un problème majeur : leur nouveau moteur de recrutement n'appréciait pas les femmes.

Depuis 2014, l'équipe développe des programmes info…

Pourquoi les citoyens du monde devraient s'en soucier

La discrimination sexuelle sur le lieu de travail empêche les femmes de réaliser leur plein potentiel. L'élimination des inégalités entre les sexes dans la main-d'œuvre augmenterait cons…

Amazon a été contraint d'abandonner son système de recrutement par IA après qu'il a été découvert qu'il était biaisé à l'encontre des candidates.

L'IA a été développée en 2014 par Amazon comme un moyen de filtrer la plupart des candidats po…

Les algorithmes sont souvent présentés comme étant supérieurs au jugement humain, éliminant les conjectures dans les décisions allant de la conduite à l'écriture d'un e-mail. Mais ils sont toujours programmés par des humains et formés sur l…

Amazon a dû abandonner son outil d'embauche d'IA parce qu'il était « sexiste » et discriminatoire à l'égard des candidates, selon un rapport de Reuters.

Les espoirs d'Amazon de créer l'outil de recrutement d'IA parfait ont été anéantis lors…

David Ryder/Getty Images PDG d'Amazon, Jeff Bezos.

Amazon a essayé de créer un outil d'intelligence artificielle pour aider au recrutement, mais il a montré un parti pris contre les femmes, rapporte Reuters.

Les ingénieurs auraient trouvé q…

Qu'est-ce que l'intelligence artificielle (IA) ? Nous examinons les progrès de l'IA et de l'automatisation en Australie par rapport au reste du monde et comment la main-d'œuvre australienne peut être affectée par ce mouvement.

L'essor de l'…

Amazon abandonne l'IA sexiste

Ce n'est pas nouveau d'apprendre que l'IA peut être une sorte de fanatique.

Amazon a abandonné un algorithme destiné à devenir un outil de recrutement car trop sexiste.

Avez-vous entendu celui sur ma femme - eh…

L'IA peut avoir des tendances sexistes. Mais, désolé, le problème est toujours nous, les humains.

Amazon a récemment abandonné un algorithme de recrutement d'employés en proie à des problèmes, selon un rapport de Reuters. En fin de compte, …

Londres | Amazon a abandonné un outil interne "sexiste" qui utilisait l'intelligence artificielle pour trier les candidatures.

Le programme a été créé par une équipe du bureau d'Amazon à Édimbourg en 2014 afin de trier les CV et de sélectio…

Des spécialistes construisaient des programmes informatiques depuis 2014 pour examiner les CV dans le but d'automatiser le processus de recherche

Cet article date de plus de 5 mois

Cet article date de plus de 5 mois

Les spécialistes du mach…

La technologie d'apprentissage automatique est de plus en plus courante dans divers secteurs, de la police au recrutement. Mais des rapports ont montré que bon nombre de ces systèmes ont des problèmes de longue date en matière de discrimina…

SAN FRANCISCO (Reuters) - Les spécialistes de l'apprentissage automatique d'Amazon.com Inc (AMZN.O) ont découvert un gros problème : leur nouveau moteur de recrutement n'aimait pas les femmes.

L'équipe avait construit des programmes informa…

Signe Amazon, avec mec. David Ryder/Getty Images

Grâce à Amazon, le monde a un nouveau récit édifiant sur les dangers d'apprendre aux ordinateurs à prendre des décisions humaines.

Selon un rapport de Reuters publié mercredi, le géant de la …

Amazon a décidé de supprimer un algorithme d'apprentissage automatique (ML) qu'il était en train de créer pour aider à automatiser le processus de recrutement, car le modèle continuait de favoriser les candidats masculins, a révélé Reuters.…

Amazon a formé une IA de lutte contre le sexisme et de filtrage des CV avec des données d'embauche sexistes, de sorte que le bot est devenu sexiste

Certaines parties de l'apprentissage automatique sont incroyablement ésotériques et difficil…

Amazon a supprimé son outil d'embauche d'intelligence artificielle après qu'il a été jugé sexiste.

Photo : © 2014, Ken Wolter

Une équipe de spécialistes connaissant bien le projet a déclaré à Reuters qu'ils construisaient des programmes inf…

Les outils de ressourcement humain de l'intelligence artificielle (IA) font fureur en ce moment et deviennent de plus en plus populaires. Les systèmes peuvent accélérer, simplifier et même réduire le coût du processus d'embauche, devenant a…

L'IA est donc peut-être l'avenir de l'embauche et du recrutement, mais elle n'en est certainement pas encore là, semble-t-il.

Si vous fondez votre apprentissage sur l'histoire qui a très probablement été biaisée en faveur des hommes, il est…

Les gourous de l'IA d'Amazon ont mis au rebut un nouveau moteur de recrutement d'apprentissage automatique plus tôt ce mois-ci. Pourquoi? Il s'est avéré que l'IA derrière elle était sexiste. Qu'est-ce que cela signifie alors que nous nous e…

Le géant de la technologie a mis en conserve son système de recrutement expérimental criblé de problèmes, selon Reuters.

Amazon, en 2014, a mis en place le système de recrutement en place, dans l'espoir de mécaniser l'ensemble du processus …

Amazon a récemment mis au rebut un outil de recrutement expérimental d'intelligence artificielle (IA) qui s'est avéré biaisé contre les femmes. À ce stade, j'espère que vous pourriez avoir quelques questions, telles que : Qu'est-ce qu'un ou…

Amazon a abandonné un outil interne "sexiste" qui utilisait l'intelligence artificielle pour trier les candidatures.

L'IA a été créée par une équipe du bureau d'Amazon à Édimbourg en 2014 afin de trier automatiquement les CV et de sélection…

Cependant, le biais apparaît également pour d'autres raisons non liées. Une étude récente sur la façon dont un algorithme diffusait des annonces faisant la promotion d'emplois STEM a montré que les hommes étaient plus susceptibles de voir l…

En décembre dernier, Synced a compilé son premier récapitulatif des "échecs de l'intelligence artificielle" des gaffes de l'IA de l'année précédente. L'IA a réalisé des progrès remarquables et de nombreux scientifiques rêvent de créer l'alg…

C'était censé faciliter la recherche de la bonne personne pour le poste. Cependant, un outil d'IA développé par Amazon pour passer au crible les embauches potentielles a été abandonné par l'entreprise après que les développeurs ont découver…

En 1964, la loi sur les droits civils interdisait aux humains qui prenaient des décisions d'embauche de faire de la discrimination fondée sur le sexe ou la race. Désormais, les logiciels contribuent souvent à ces décisions d'embauche, en ai…

Je suis chez moi en train de jouer à un jeu vidéo sur mon ordinateur. Mon travail consiste à gonfler un ballon à la fois et à gagner le plus d'argent possible. Chaque fois que je clique sur "Pump", le ballon se dilate et je reçois cinq cent…

Les outils de recrutement artificiellement intelligents ne réduisent pas les préjugés et n'améliorent pas la diversité, selon les chercheurs dans une étude.

"Il y a un intérêt croissant pour de nouvelles façons de résoudre des problèmes tel…

Variantes

Incidents similaires

Did our AI mess up? Flag the unrelated incidents

AI Beauty Judge Did Not Like Dark Skin

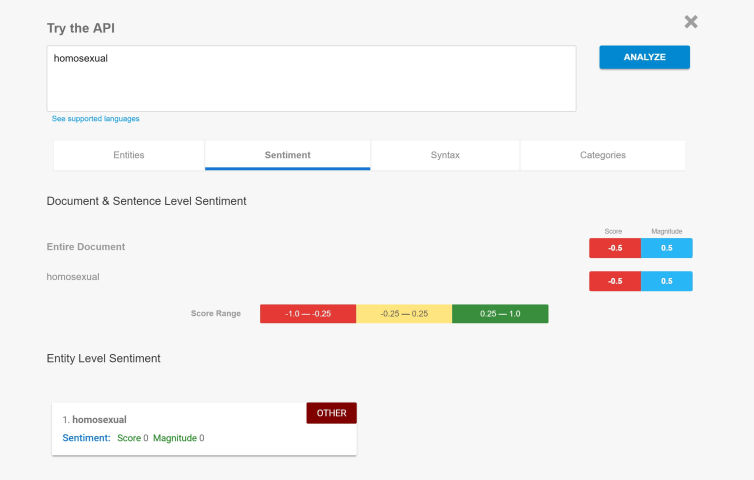

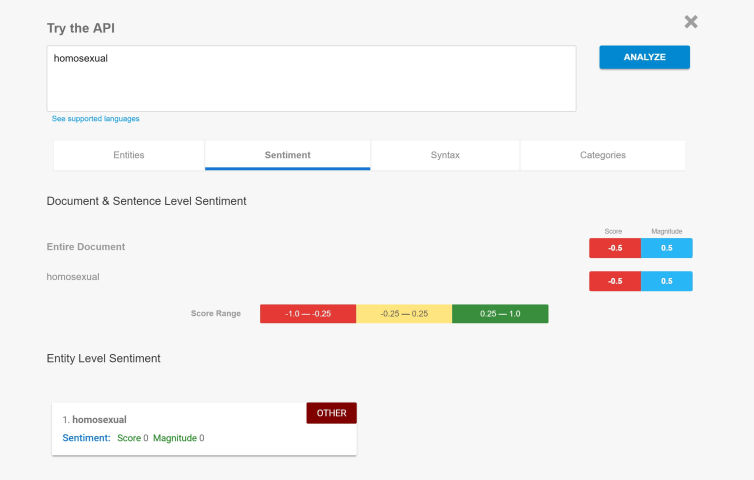

Biased Sentiment Analysis

Racist AI behaviour is not a new problem

Incidents similaires

Did our AI mess up? Flag the unrelated incidents

AI Beauty Judge Did Not Like Dark Skin

Biased Sentiment Analysis