Incident 976: Des influenceurs de la santé gynécologique et obstétricale générés par l'IA sur TikTok ont utilisé de faux diplômes médicaux pour promouvoir des conseils douteux

Outils

Entités

Voir toutes les entitésStatistiques d'incidents

Rapports d'incidents

Chronologie du rapport

Les créateurs d'IA sur TikTok atteignent des sommets en matière de spam avec une application appelée Captions, qui produit des tonnes de faux « médecins de chatte ». Depuis fin 2024, ces « créateurs » artificiels revendiquent « 13 ans d'exp…

Une pomme par jour éloigne-t-elle l'IA ?

Des créateurs dénoncent les pr�étendus médecins deepfakes qui escroquent les utilisateurs des réseaux sociaux avec des conseils médicaux infondés.

Sur TikTok, une recherche donne accès à des dizaines …

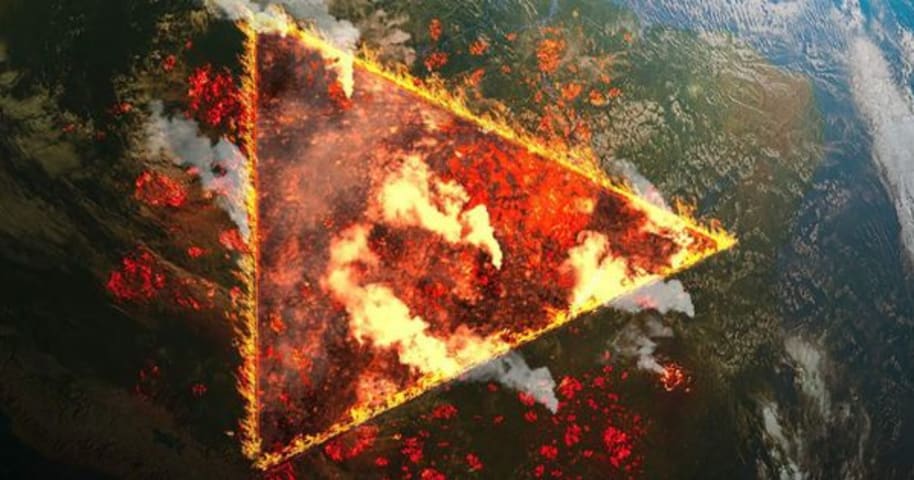

Alors que l'intelligence artificielle évolue rapidement, distinguer le vrai du faux en ligne devient de plus en plus difficile.

Au départ, les deepfakes ont suscité des inquiétudes quant à la désinformation et aux intentions malveillantes. …

Un médecin, populaire en tant qu'influenceur en matière de conseils de santé sur la plateforme vidéo chinoise TikTok, s'est révélé être un avatar créé à l'aide de l'intelligence artificielle (IA).

Le quotidien britannique The Independent a …

Des experts mettent en garde contre les « médecins deepfake » après qu'une série de vidéos contenant des conseils médicaux infondés a inondé les réseaux sociaux.

Certains de ces soi-disant « médecins » se prétendent experts dans d'autres do…

Variantes

Incidents similaires

Did our AI mess up? Flag the unrelated incidents

Incidents similaires

Did our AI mess up? Flag the unrelated incidents