Incidente 74: La policía de Detroit arrestó injustamente a un hombre negro debido a un FRT defectuoso

Herramientas

Entidades

Ver todas las entidadesClasificaciones de la Taxonomía CSETv0

Detalles de la TaxonomíaProblem Nature

Specification, Assurance

Physical System

Software only

Level of Autonomy

High

Nature of End User

Amateur

Public Sector Deployment

Yes

Data Inputs

biometrics, images, camera footage

Clasificaciones de la Taxonomía CSETv1

Detalles de la TaxonomíaIncident Number

74

Clasificaciones de la Taxonomía GMF

Detalles de la TaxonomíaKnown AI Goal Snippets

(Snippet Text: On a Thursday afternoon in January, Robert Julian-Borchak Williams was in his office at an automotive supply company when he got a call from the Detroit Police Department telling him to come to the station to be arrested., Related Classifications: Face Recognition)

Risk Subdomain

1.3. Unequal performance across groups

Risk Domain

- Discrimination and Toxicity

Entity

AI

Timing

Post-deployment

Intent

Unintentional

Informes del Incidente

Cronología de Informes

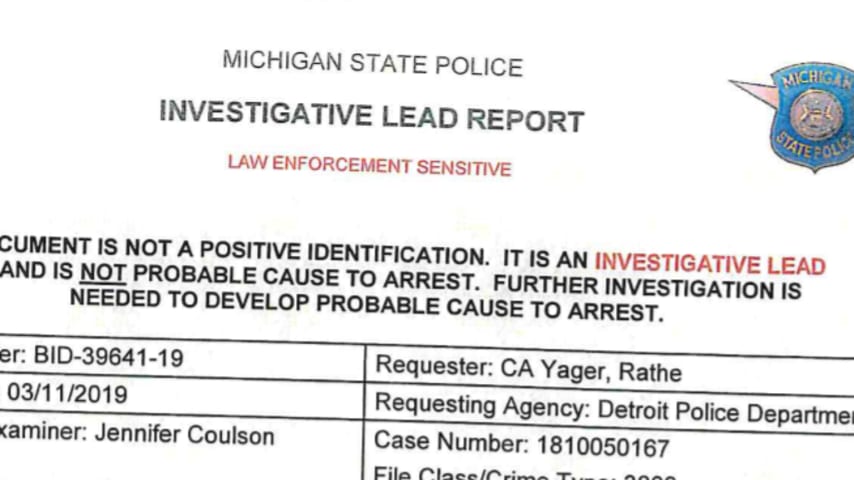

La policía de Detroit arrestó injustamente a Robert Julian-Borchak Williams en enero de 2020 [por un incidente de robo que había ocurrido dos años antes] (https://www.nytimes.com/2020/06/24/technology/facial-recognition-arrest. html). Aunqu…

"Nota: en respuesta a este artículo, la oficina del fiscal del condado de Wayne dijo que Robert Julian-Borchak Williams podría borrar el caso y sus datos de huellas dactilares. "Pedimos disculpas", dijo el fiscal, Kym L. Worthy, en un comun…

Actualizado a las 21:05 ET miércoles

La policía de Detroit estaba tratando de averiguar quién robó cinco relojes de una tienda minorista de Shinola. Las autoridades dicen que el ladrón se fue con un valor estimado de $ 3,800 en mercancía.

L…

El miércoles por la mañana, la ACLU anunció que presentaría una denuncia contra el Departamento de Policía de Detroit en nombre de Robert Williams, un residente negro de Michigan a quien el grupo dijo que es una de las primeras personas arr…

La policía de Detroit ha utilizado tecnología de reconocimiento facial altamente poco confiable casi exclusivamente contra personas negras en lo que va de 2020, según las propias estadísticas del Departamento de Policía de Detroit. El uso d…

Sesgo racial y reconocimiento facial. Hombre negro en Nueva Jersey arrestado por la policía y pasa diez días en la cárcel después de una coincidencia de reconocimiento facial falso

Las preocupaciones sobre la precisión y el sesgo racial sob…

Teaneck acaba de prohibir la tecnología de reconocimiento facial para la policía. Este es el por qué

Show Caption Hide Caption Programa de reconocimiento facial que funciona incluso si usa una máscara Una empresa japonesa dice que ha desarr…

Un hombre de Michigan demandó a la policía de Detroit después de que el software de reconocimiento facial del departamento lo arrestó injustamente e identificó falsamente como sospechoso de hurto en una tienda en una de las primeras demanda…

Desde que un oficial de policía de Minneapolis mató a George Floyd en marzo de 2020 y reinició las protestas masivas de Black Lives Matter, las comunidades de todo el país han estado repensando la aplicación de la ley, desde el escrutinio g…

ROBERT WILLIAMS ESTABA trabajando en el jardín con su familia una tarde de agosto pasado cuando su hija Julia dijo que necesitaban una reunión familiar de inmediato. Una vez que todos estuvieron dentro de la casa, la niña de 7 años cerró to…

translated-es-In January 2020, Robert Williams spent 30 hours in a Detroit jail because facial recognition technology suggested he was a criminal. The match was wrong, and Mr. Williams sued.

On Friday, as part of a legal settlement over his…

Variantes

Incidentes Similares

Did our AI mess up? Flag the unrelated incidents

Predictive Policing Biases of PredPol

Incidentes Similares

Did our AI mess up? Flag the unrelated incidents